Die Energiewende stellt Betreiber von Versorgungsnetzen, insbesondere für Gas, Strom und Wärme, vor die Herausforderung, die Weiterentwicklung ihrer Netze und Anlagen kaufmännisch und technisch deutlich differenzierter als bislang erforderlich zu beplanen. Der wesentliche Treiber sind die anstehenden, massiven Investitionen in den Infrastrukturneu- bzw. -umbau. Sie sind notwendig, um die langfristigen Ziele im Bereich der Dekarbonisierung, beim Ausbau erneuerbarer Energiequellen sowie bei der Dezentralisierung der Energieerzeugung zu erreichen.

Als Konsequenz steigen bei den Netzbetreibern die Anforderungen der tangierten Fachabteilungen wie Netzwirtschaft, Finanz- und Rechnungswesen, Controlling, Bau und Betrieb an die verwendeten Datenmodelle. Wesentliche Kriterien sind dabei die Verfügbarkeit, Qualität und Granularität der Daten. Die Datenverfügbarkeit bezeichnet, ob und welche Daten aus den Systemen für eine fundierte kaufmännische, regulatorische und technische Planung bereitgestellt gestellt werden. Die Datenqualität hängt davon ab, ob die verfügbaren Daten aktuell, vollständig und korrekt sind. Die Datengranularität wiederum misst, ob die bisherige Erfassung und Aufbereitung der Daten detailliert genug und damit für erhöhte Ansprüche geeignet ist.

Diese Entwicklung betrifft die verschiedenen Versorgungssparten gleichermaßen, wobei die regulatorischen Vorgaben und die geopolitische Rahmenbedingungen die Situation speziell in den Sparten Strom und Gas nochmals verschärfen. Auf der funktionalen Ebene ist es vor allem das Asset Management, das als Drehscheibe zwischen den wesentlichen Unternehmensbereichen besonders herausgefordert wird. Dass sich die Situation zuspitzt, hat mehrere Ursachen.

Was fehlt den Datenlandschaften in der Energiewirtschaft?

Zunächst sind die heute genutzten Datenmodelle oftmals historisch den in verschiedenen Einheiten der Unternehmen gewachsen. Bei der Konzeption der Modelle und bei der Sammlung der Daten fand typischerweise keine interdisziplinäre bzw. bereichsübergreifende Betrachtung satt. Darüber hinaus gab es in der Regel keine ganzheitliche Bewertung einer optimalen Gesamtlösung. Diese würde erreicht, indem man ermittelt, welche Informationen die unterschiedlichen Anwender wie z.B. kaufmännische und technische Abteilungen nutzen, und diese Erkenntnisse in dem Modell berücksichtigt.

Weiterhin leiden die heute genutzten Datenmodelle oftmals darunter, dass die IT-Systemlandschaften fragmentiert und an den Schnittstellen zwischen unterschiedlichen Funktionsbereichen nur unzureichend oder nicht miteinander verknüpft sind, beispielsweise, wenn bei einem Netzbetreiber der technisch-betriebliche, der bauende und der kaufmännische Bereich verschiedene Systeme nutzen. Die Folge sind regelmäßige Systembrüche und händische Eingriffe, mit unvermeidbaren Ineffizienzen und Fehlerquellen. Zudem sind keine Vergleichbarkeit zwischen den Funktionsbereichen und keine übergreifende Steuerung möglich, weil die gemeinsame Datengrundlage fehlt.

Die wechselnden Anforderungen an die Datenerhebung und sich ändernde Datenerfassungs- und Verwaltungsprozesse stellen die betroffenen Unternehmen ebenfalls vor große Herausforderungen. Besonderer Handlungsdruck entsteht durch einen Faktor, dessen Gewicht heute so groß ist wie nie zuvor, nämlich die Frage der Allokation der Investitionsmittel. Einerseits stehen viele Versorgungsunternehmen vor einem Investitionsstau, und müssen entscheiden, in welche der oft überfälligen Projekte und Maßnahmen sie zuerst investieren. Die Dekarbonisierung stellt dabei mitunter ganz neue, zusätzliche Anforderungen, wie etwa die Notwendigkeit von Desinvestitionen. Diese könnten bald in einem nie da dagewesenen Umfang nötig werden, falls zum Beispiel das Gasnetz in einem signifikanten Umfang zurückgebaut werden muss. Gleichzeitig müssen die Versorger, um bei der Energiewende und Zukunftsthemen wie der dezentralen Stromversorgung handlungsfähig zu bleiben, massiv investieren und mitunter komplett neue Netze bauen – und das, während sie bereits mit den aktuellen Herausforderungen zu kämpfen haben. Sie stehen einmal mehr vor der Frage, wo sie die knappen Mittel allokieren.

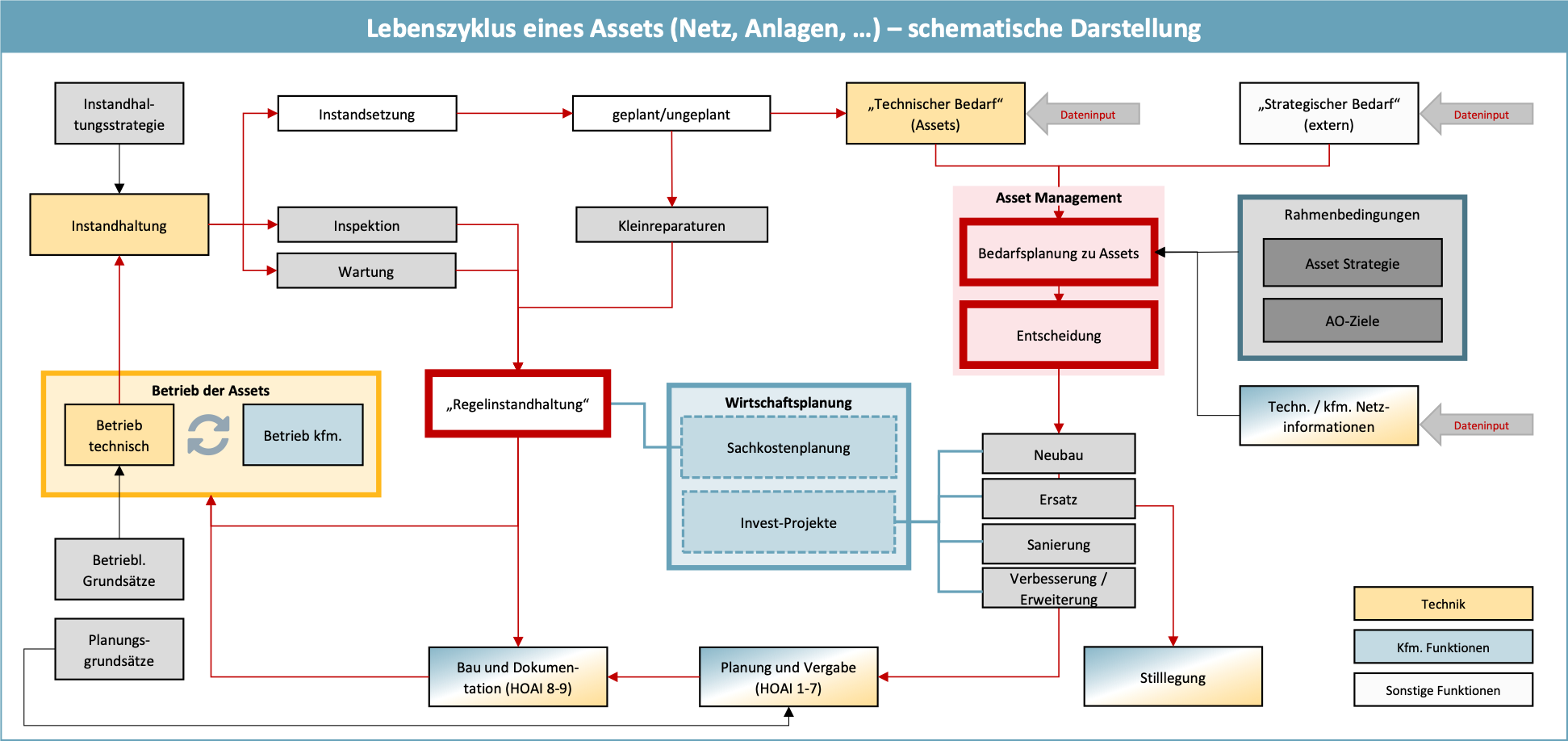

Gute Entscheidungen im gesamten Lebenszyklus der Assets

In der Folge bieten die oftmals grobkörnigen, veralteten und nicht über Fachabteilungen hinweg integrierten Datenmodelle keine ausreichende Basis, um mit komplexen Fragestellungen souverän umgehen zu können. Gerade im Asset Management fällt es zunehmend schwer, strategische Prioritäten zu definieren und Entscheidungen unter Berücksichtigung kaufmännischer, technischer und regulatorischer Gesichtspunkte zu treffen.

Das folgende Beispiel verdeutlicht die Bedeutung des Datenmodells. In diesem Fall ist eine Trafostation im IT-System des Betreibers strukturiert angelegt – allerdings werden die technischen Zustände der verschiedenen Bauteile im Betrieb nur bedingt strukturiert erfasst und nicht vollständig mit den kaufmännischen Daten und Informationen zur Trafostation synchronisiert. Die Folge: Die kaufmännischen Implikationen der technischen Zustände des Assets „Trafostation“ sind oftmals unklar. Somit fehlt ein wichtiger Baustein als Grundlage, um die kaufmännischen Auswirkungen einzuschätzen und z.B. auf Basis einer Zustands-/Wichtigkeits-Matrix Investitionsentscheidungen zu treffen.

Dieses Beispiel verdeutlicht, dass ein performantes Datenmodell die Grundlagen sowohl im kaufmännischen (Langfristige, mittelfristige und Jahresplanung) als auch im technischen Planungsprozess (Grobplanung, Feinplanung, Bau, Betrieb, Rückbau) liefert. Dadurch ermöglicht es die integrierte Optimierung beider Prozesse und liefert die notwendigen Informationen, um Investitions- und Unterhaltsentscheidungen konsistent und aussagekräftig zu treffen.

Abbildung: Asset-Lebenszyklus am Beispiel „MS-Leitung“:

Zukunftsfähiges Datenmodell als Basis für kfm./reg./techn. optimierte Asset-Bewirtschaftung

Auf dem Weg zu einem zukunftsfähigen Datenmodell

Welche Schritte sind nun notwendig, um Datenmodelle aufzubauen, die ein nachhaltig erfolgreiches, zukunftsfähiges Asset Management unterstützen? Hier lassen sich vier wesentliche Aspekte definieren.

- Erfassung der Informationsbedarfe: Die Basis für die weitere Planung sollte immer die Ermittlung der Informationsbedarfe der involvierten Fachabteilungen sein, um Klarheit und Transparenz hinsichtlich der zukünftigen Anforderungen zu erhalten. Weiterhin ist zu klären, wie Daten aufgenommen und konsolidiert werden sollen. Hierzu ist ein Gesamtüberblick notwendig, z.B. welche Fachabteilung welche Daten in welcher Qualität, Granularität und Aktualität benötigt.

- Modellentwicklung und Definition der „Bezugsobjekte“. Die tangierten Fachabteilungen (insbesondere Assetmanagement, Netzwirtschaft, Finanz-Rechnungswesen, Controlling, Bau und Betrieb) definieren gemeinsam die relevanten „Bezugsobjekte“ für das Datenmodell. Ein Bezugsobjekt kann z.B. ein bestimmter Versorgungsabschnitt, eine Stichleitung in einer Ortschaft, eine Armaturengruppe oder eine Ortsnetzstation sein. Bei der Definition eines Bezugsobjektes hilft die Orientierung am Kriterium des „eigenständigen, aktivierbaren Wirtschaftsguts“. In Bezug auf das Datenmodell muss das Bezugsobjekt den sogenannten Mindestdetaillierungsgrad abdecken.

- Ableitung von „Datenstrukturen“: Da jede Fachabteilung andere Anforderungen an die notwendigen Informationen zu einem Bezugsobjekt hat, werden, basierend auf den erfassten Anforderungen, für jede Fachabteilung die notwendigen Datenstrukturen als Modell aufgebaut. Im Bereich Bau/Projektumsetzung z.B. werden häufig PSP-Elemente als die führende Größe für Datenstrukturen verwendet. Daraus ergeben sich zu einem Bezugsobjekt nach Fachabteilungen geclusterte Datenstrukturen. Wesentlich ist, dass die verschiedenen Datenstrukturen zu einem Bezugsobjekt in ihrem Aufbau synchronisiert sind und „zueinander passen“, bzw. inhaltlich zueinander gemappt werden. Im Ergebnis werden die Datenstrukturen für alle Bezugsobjekte nach den individuellen Anforderungen der Fachabteilungen abgebildet.

- Modellumsetzung: Zunächst werden die notwendigen IT-technischen Anpassungen und sowie die Entwicklungsschritte als Anforderungskatalog abgeleitet. Auf dieser Basis wiederum erfolgt die technische Realisierung.

Die Verknüpfung fachlicher Anforderungen an die Datenausprägung mit den Möglichkeiten technologischer Tools zur Abbildung der Daten ermöglicht eine iterative und kontinuierliche Optimierung der Entscheidungs- und Steuerungsprozesse. Dadurch bleibt das Asset Management agil und effizient und unterstützt auch die anderen Organisationsbereiche bei der Erfüllung ihrer Aufgaben in einem anspruchsvollen und schwer prognostizierbaren Marktumfeld.